Trí tuệ nhân tạo có thể khiến tin giả có độ chân thực bất ngờ

Các chuyên gia Ngân hàng VTB vừa lý giải tại sao AI lại "bịa đặt" thông tin một cách có vẻ hợp lý, từ việc tạo ra những cuốn sách không tồn tại đến đưa ra chẩn đoán y tế hư cấu.

Điều đáng lo ngại là những thông tin sai lệch này thường trông rất thuyết phục, khiến người dùng khó phát hiện.

Bản chất của "ảo giác AI"

"Ảo giác AI" là hiện tượng mạng nơ ron tạo ra văn bản hợp lý nhưng chứa các sự kiện hư cấu - đây là đặc thù trong cách học và vận hành của các mô hình ngôn ngữ.

Theo các nhà phân tích tại VTB, AI không đưa ra câu trả lời dựa trên sự hiểu biết thực sự, mà dựa trên các kết nối xác suất trong dữ liệu huấn luyện.

Khi thiếu thông tin, mô hình sẽ "nghĩ ra" các chi tiết để tạo thành câu trả lời hoàn chỉnh. Các hạn chế về mẫu dữ liệu và việc không thể kiểm tra thông tin theo thời gian thực làm tăng nguy cơ sai sót, đặc biệt trong các lĩnh vực hiếm gặp hoặc chuyên biệt.

Những ví dụ đáng lo ngại

Ông Lev Merkushov, người đứng đầu bộ phận giải pháp AI của VTB, cho biết có những trường hợp mạng nơ ron đưa ra danh sách những cuốn sách không tồn tại hoặc tạo ra các điều kiện sản phẩm hư cấu.

"Mô hình không kiểm tra thông tin thực tế, mà chọn câu trả lời có khả năng xảy ra cao nhất, do đó các lỗi trông có vẻ hợp lý nhưng lại gây nhầm lẫn", ông giải thích.

Giới chuyên gia đã tổng kết một số ví dụ phổ biến về hiện tượng này:

Trong nghiên cứu học thuật: AI tạo ra các trích dẫn giả bằng cách trích dẫn các bài báo không tồn tại hoặc gán kết quả cho sai tác giả, gây khó khăn cho các nhà nghiên cứu.

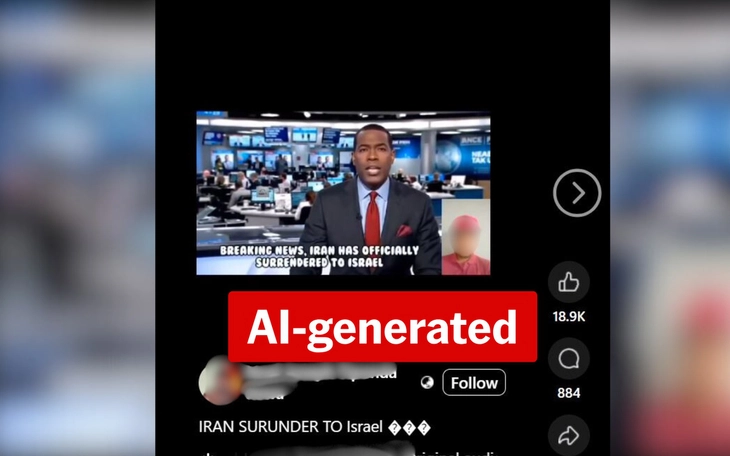

Trong báo chí: Tin tức do AI tạo ra có thể chứa các sự kiện, nhân vật hoặc số liệu thống kê hư cấu, dẫn đến thông tin sai lệch đáng lo ngại, đặc biệt khi diễn giải các phát biểu chính trị.

Trong y tế: Các mô hình AI có thể đưa ra chẩn đoán và khuyến nghị điều trị hư cấu, điều này có thể gây nguy hiểm cho người dùng nếu không có sự tham khảo ý kiến chuyên gia.

Giải pháp khắc phục

Để giảm thiểu "ảo giác AI", ông Merkushov đề xuất xây dựng các yêu cầu rõ ràng và tiến hành xác minh kết quả bằng con người.

"Công thức càng chính xác và dễ hiểu thì mô hình càng ít có khả năng bắt đầu ảo tưởng. Tuy nhiên, phương pháp kiểm soát đáng tin cậy nhất vẫn là việc kiểm tra kết quả cẩn thận của con người", ông nhấn mạnh.

Chuyên gia Alexey Pustynnikov cũng của VTB cho rằng việc lọc dữ liệu nguồn và chỉ đưa các nguồn đã được xác minh vào đào tạo AI là rất quan trọng, mặc dù điều này làm tăng chi phí tạo mô hình.

VTB nhấn mạnh rằng việc sử dụng trí tuệ nhân tạo không chỉ đòi hỏi sự trưởng thành về công nghệ, mà còn đòi hỏi thái độ có trách nhiệm đối với chất lượng dữ liệu, tính minh bạch của các thuật toán và khả năng kiểm soát kết quả.

BÌNH LUẬN HAY